Ce qui se passe

Nvidia lance une nouvelle puce, la H100 « Hopper », qui a le potentiel d’accélérer l’intelligence artificielle qui balaie l’industrie technologique.

Pourquoi est-ce important

La puce aide à cimenter l’avance de Nvidia dans la technologie qui révolutionne tout dans l’informatique, des voitures autonomes à la traduction du langage au fur et à mesure que les gens parlent.

Nvidia commencera à vendre une nouvelle puce d’accélération de l’IA plus tard cette année, dans le cadre des efforts de l’entreprise pour assurer son leadership dans une révolution informatique qui alimente tout, de la dictée automatique des e-mails aux voitures autonomes.

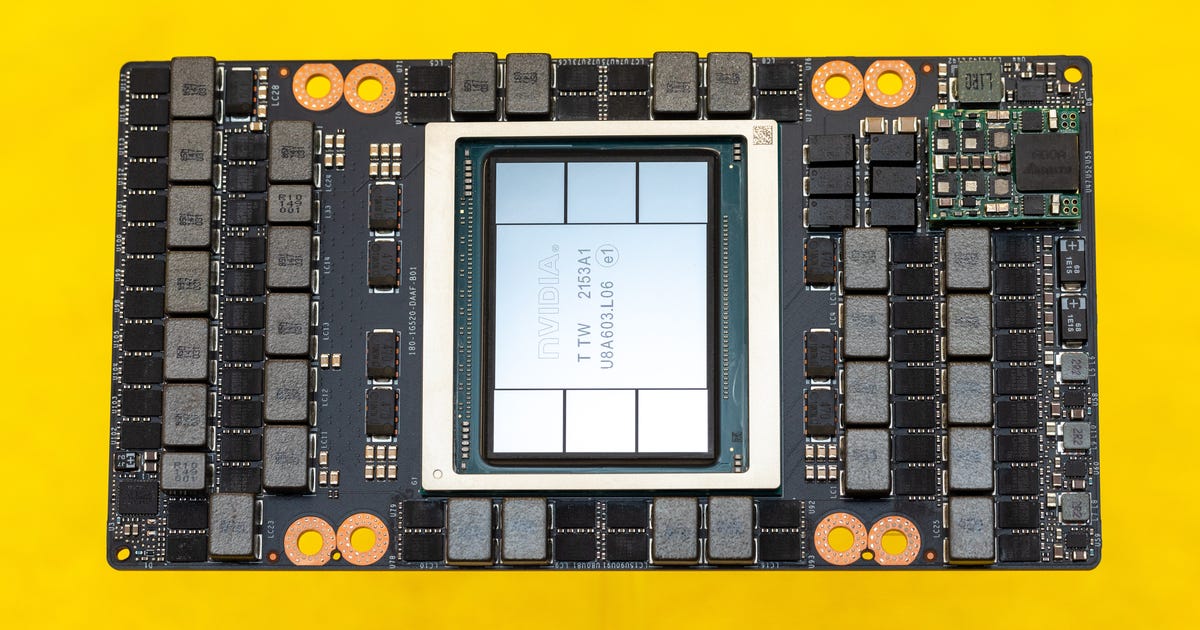

Le processeur H100 « Hopper », que le directeur général de Nvidia, Jensen Huang, a dévoilé en mars, devrait commencer à être livré au prochain trimestre. Le processeur a 80 milliards de transistors et mesure 814 millimètres carrés, ce qui est presque aussi grand que physiquement possible avec l’équipement de fabrication de puces d’aujourd’hui.

Le H100 est en concurrence avec d’énormes processeurs IA gourmands en énergie comme le MI250X d’AMD, le TPU v4 de Google et le prochain Ponte Vecchio d’Intel. Ces puces sont des goliaths que l’on trouve le plus souvent dans l’environnement préféré pour former des systèmes d’IA, des centres de données remplis de racks de matériel informatique et de gros câbles d’alimentation en cuivre.

La nouvelle puce incarne l’évolution de Nvidia d’un fabricant d’unités de traitement graphique utilisées pour les jeux vidéo à une centrale d’IA. La société l’a fait en adaptant les GPU aux mathématiques particulières de l’IA, comme la multiplication de tableaux de nombres. CNET a eu un aperçu exclusif des puces H100 Hopper et du nouveau bâtiment Voyager de Nvidia qui abritera les travaux de développement matériel et logiciel.

Les circuits pour accélérer l’IA deviennent de plus en plus importants à mesure que la technologie arrive dans tout, des iPhones à Aurora, qui devrait être le supercalculateur le plus rapide au monde. Des puces comme le H100 sont essentielles pour accélérer des tâches telles que la formation d’un modèle d’IA pour traduire en direct le discours en direct d’une langue à une autre ou pour générer automatiquement des sous-titres vidéo. Des performances plus rapides signifient que les développeurs d’IA peuvent s’attaquer à des tâches plus difficiles comme les véhicules autonomes et accélérer leur expérimentation, mais l’un des principaux domaines d’amélioration concerne le langage de traitement.

Linley Gwennap, analyste chez TechInsights, affirme que le H100, ainsi que les outils logiciels de Nvidia, consolide sa position sur le marché des processeurs d’IA.

« Nvidia domine ses concurrents », a écrit Gwennap dans un rapport en avril.

Pindrop, un client de longue date de Nvidia qui utilise l’analyse vocale basée sur l’IA pour aider les représentants du service client à authentifier les clients légitimes et à repérer les escrocs, affirme que les progrès constants du fabricant de puces lui ont permis de s’étendre à l’identification des deepfakes audio. Les deepfakes sont des simulations informatiques sophistiquées qui peuvent être utilisées pour perpétrer des fraudes ou diffuser des informations erronées.

« Nous ne pourrions pas y arriver si nous n’avions pas la dernière génération de GPU Nvidia », a déclaré Ellie Khoury, directrice de la recherche de l’entreprise.

La formation de leur système d’IA implique le traitement d’une énorme quantité d’informations, y compris les données audio de 100 000 voix, chacune manipulée de plusieurs manières pour simuler des choses comme des bavardages en arrière-plan et de mauvaises connexions téléphoniques. C’est pourquoi les avancées du H100, telles que la mémoire étendue et un traitement plus rapide, sont importantes pour les clients de l’IA.

Nvidia estime que son H100 est globalement six fois plus rapide que le prédécesseur A100 que la société a lancé il y a deux ans. Un domaine important qui en bénéficie définitivement est le traitement du langage naturel. Également connu sous le nom de PNL, le domaine de l’IA aide les ordinateurs à comprendre votre discours, à résumer des documents et à traduire des langues, entre autres tâches.

Nvidia est un acteur important du NLP, un domaine à l’avant-garde de l’IA. Le système Palm AI de Google peut dissocier la cause et l’effet dans une phrase, écrire du code de programmation, expliquer des blagues et jouer au jeu de film emoji. Mais les GPU flexibles de Nvidia sont populaires auprès des chercheurs. Par exemple, Meta, la société mère de Facebook, a publié cette semaine gratuitement une technologie NLP sophistiquée pour accélérer la recherche sur l’IA, et elle fonctionne sur 16 GPU Nvidia.

Avec le H100, les chercheurs en NLP et les développeurs de produits peuvent travailler plus rapidement, a déclaré Ian Buck, vice-président du groupe informatique hyperscale et haute performance de Nvidia. « Ce qui a pris des mois devrait prendre moins d’une semaine. »

Le H100 offre une grande avancée dans les transformateurs, une technologie d’intelligence artificielle créée par Google qui peut évaluer l’importance du contexte autour des mots et détecter les relations subtiles entre les informations d’un domaine à l’autre. Les données telles que les photos, la parole et le texte utilisées pour former l’IA doivent souvent être soigneusement étiquetées avant utilisation, mais les modèles d’IA basés sur des transformateurs peuvent utiliser des données brutes comme de vastes étendues de texte sur le Web, a déclaré Aidan Gomez, co-fondateur de la startup du langage AI. Adhérer.

« Il lit Internet. Il consomme Internet », a déclaré Gomez, puis le modèle d’IA transforme ces données brutes en informations utiles qui capturent ce que les humains savent du monde. Les transformateurs d’effet « ont fait avancer ma chronologie des décennies » en ce qui concerne le rythme des progrès de l’IA.

Nous pouvons tous bénéficier de la capacité du H100 à accélérer la recherche et le développement de l’IA, a déclaré Hang Liu, professeur adjoint au Stevens Institute of Technology. Amazon peut repérer plus de fausses critiques, les fabricants de puces peuvent mieux agencer les circuits des puces et un ordinateur peut transformer vos mots en chinois au fur et à mesure que vous les prononcez, a-t-il déclaré. « En ce moment, l’IA remodèle complètement presque tous les secteurs de la vie commerciale. »